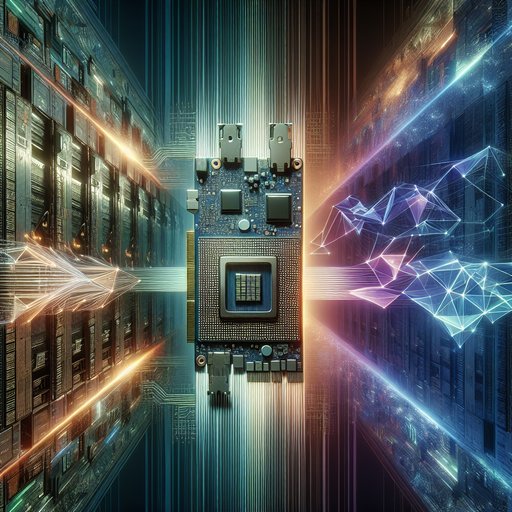

Grafische processors begonnen als ondersteunende elementen voor de CPU, die pixels over het scherm verplaatsten en vensterdesktops versnelden. In de loop van meer dan dertig jaar hebben zorgvuldige architectonische aanpassingen en een volwassen softwarestack hen getransformeerd tot de dominante parallelle rekeneenheden van onze tijd. Het CUDA-platform van NVIDIA heeft grootschalige algemene programmatuur mogelijk gemaakt, en deep learning vond al snel een natuurlijke thuisbasis op deze throughput-georiënteerde hardware. Tegelijkertijd bracht cryptocurrency-mining zowel de ruwe prestaties als de marktschommelingen aan het licht die massale parallelisatie kan ontketenen. Het volgen van deze ontwikkeling laat zien hoe een ooit gespecialiseerde randapparatuur centraal kwam te staan in wetenschappelijke ontdekkingen, moderne AI en zelfs financiële systemen.

De koers van de GPU is belangrijk omdat het laat zien hoe technische beperkingen de hele richting van computing kunnen ombuigen. Grafische adapters waren ooit nauw geoptimaliseerd voor bitmaps en scan-out, maar de onophoudelijke vraag naar realisme in games leidde tot hardware die uitblonk in het parallel uitvoeren van veel eenvoudige bewerkingen. Diezelfde vaardigheden—hoge geheugensnelheid, snelle contextwisseling en enorme gelijktijdigheid—sluiten naadloos aan bij lineaire algebra. Hierdoor werden GPU's de standaardmotor voor uiteenlopende taken zoals het trainen van neurale netwerken, het versnellen van wetenschappelijke simulaties en, een tijdlang, het minen van cryptocurrencies.

Hun opkomst heeft ook de toeleveringsketens, datacenterontwerpen en programmeermodellen in de industrie veranderd. Vroege pc's vertrouwden in de jaren '80 op eenvoudige grafische adapters zoals de MDA en CGA van IBM, die later gestandaardiseerd werden rond VGA voor analoge uitvoer. Toen grafische gebruikersinterfaces zich verspreidden, ontwikkelden leveranciers zoals S3, Matrox en ATI 2D-versnellers die BitBLT, lijntekeningen en video-overlay versnelden. De Accelerated Graphics Port aan het eind van de jaren '90 verbeterde de doorvoer tussen CPU en grafisch geheugen, wat rijkere scènes mogelijk maakte.

Deze ontwerpen volgden nog steeds een grotendeels vaste functie: de kaart voerde een beperkte set grafische taken zeer snel uit, met weinig ruimte voor algemene berekeningen. De drang naar 3D-realisme veranderde de situatie. 3dfx's Voodoo maakte in het midden van de jaren '90 consumenten 3D-versnelling populair, terwijl API's zoals OpenGL en Direct3D een pipeline vastlegden die efficiënt door hardware kon worden geïmplementeerd. NVIDIA's GeForce 256 in 1999 integreerde hardware voor transformaties en belichting en introduceerde de term "GPU", wat een bredere rol weerspiegelt dan alleen weergeven.

Programmeerbare shaders uit de DirectX 8-periode maakten het ontwikkelaars mogelijk om kleine programma's aan te leveren die per vertex en per pixel draaiden, terwijl de unificerende shaders uit de DirectX 10-periode, die debuteerden met NVIDIA's G80 (GeForce 8800) in 2006, de lijnen van vaste functies vervaagden tot een grote pool van algemene rekeneenheden. Het resultaat was een zeer parallelle processorarray met een geheugenhierarchie die, hoewel afgestemd op grafische toepassingen, steeds bruikbaarder werd voor andere dataparallelle taken. Onderzoekers verkenden snel algemene berekeningen op dit nieuwe substraat, aanvankelijk door shader-talen te buigen en later door op maat gemaakte tools te bouwen. Projecten zoals BrookGPU van Stanford toonden aan dat veel wetenschappelijke kernels konden worden gemapt op grafische pipelines, wat het latente rekencapaciteit benadrukte.

In 2006 introduceerde NVIDIA CUDA, een C-achtige programmeermodel dat threads, blokken en een geheugenhierarchie expliciet ontworpen voor doorvoer blootlegde. CUDA werd geleverd met geoptimaliseerde bibliotheken zoals cuBLAS en cuFFT, waardoor ontwikkelaars krachtige bouwstenen kregen. OpenCL volgde in 2008 als een vendor-neutraal standaard, en in de loop der tijd vulden Vulkan compute, DirectCompute en Metal de cross-platform opties aan. Deep learning verstevigde de rol van de GPU in high-performance computing.

In 2012 werd het AlexNet-convolutionele neurale netwerk getraind op NVIDIA GPU's met behulp van CUDA-gebaseerde code, wat baanbrekende resultaten op ImageNet opleverde en aantoonde dat backpropagation en convoluties gedijen op GPU-parallelisme. NVIDIA's cuDNN-bibliotheek, geïntroduceerd in 2014, standaardiseerde high-performance primitieve voor neurale netwerken en werd een cruciale afhankelijkheid voor frameworks zoals TensorFlow en PyTorch. De hardware ontwikkelde zich mee: Volta's V100 (2017) voegde Tensor Cores toe voor gemengde precisie matrixberekeningen, later uitgebreid in Ampere's A100 (2020) en Hopper's H100 (2022) met ondersteuning voor BF16 en FP8 en de Transformer Engine voor geautomatiseerd precisiebeheer. Multi-GPU-training schaalde via NCCL voor collectieven en hogesnelheidsverbindingen zoals NVLink en NVSwitch, waardoor single-node en multi-node clusters steeds grotere modellen konden trainen.

Datacenter-GPU's werden systemen in plaats van alleen chips, met verpakkingen, geheugen en verbindingen ontworpen voor langdurige AI-werkbelastingen. High Bandwidth Memory (HBM2 en HBM3) zorgde voor enorme doorvoer op de chip om duizenden cores van stroom te voorzien, terwijl SXM-modules en compacte moederborden de energie- en thermische efficiëntie optimaliseerden. Kenmerken zoals Multi-Instance GPU (MIG) op Ampere verdeelden een enkele accelerator in geïsoleerde delen, wat de benutting voor gemengde werkbelastingen verbeterde. NVIDIA's DGX en HGX-ontwerpen gaven referentienormen voor leveranciers en cloudproviders, terwijl containerized drivers en CUDA-compatibele runtimes de implementatie op grote schaal vereenvoudigden.

AMD ontwikkelde een alternatief platform met ROCm en HIP op accelerators zoals MI200 en MI300, en portabiliteitslagen zoals OpenCL en SYCL breidden de keuze voor heterogene computing uit. De vraag van consumenten vertelde een parallel verhaal in cryptocurrency. Vroeg Bitcoin-minen begon op CPU's, maar tegen 2010 domineerden GPU's vanwege de veel hogere doorvoer op SHA-256-werkbelastingen, waarbij sommige AMD Radeon-kaarten uitblonken dankzij efficiënte integer-pijplijnen. Gespecialiseerde ASIC's vervingen GPU's voor Bitcoin rond 2013-2014, maar Ethereum's geheugen-harde Ethash hield GPU's relevant tot de overgang van het netwerk naar proof of stake in 2022.

De mining-booms in 2017 en opnieuw in 2020-2021 verscherpten de GPU-aanvoer, wat leidde tot maatregelen zoals "Lite Hash Rate"-varianten en invloed had op prijzen en beschikbaarheid voor gamers en onderzoekers. Deze cycli benadrukten hoe een enkele toepassingsklasse de hele hardwaremarkt kan beïnvloeden wanneer de grondstof parallelle rekencapaciteit is. Het verhaal van programmeerbaarheid verklaart veel van de blijvende verschuiving van grafische naar algemene computing. De consistente API's van CUDA, evoluerende wiskundebibliotheken en tooling maakten het praktisch om wetenschappelijke codes en machine learning-kernels te porteren zonder shader-code met de hand te schrijven.

Vendor-neutrale opties zorgden ervoor dat onderzoekers en bedrijven hun inzetten konden spreiden, zelfs terwijl een groot deel van het deep learning-ecosysteem standaardiseerde op CUDA en cuDNN voor prestaties. Interoperabiliteitsstandaarden zoals ONNX hielpen bij de modelportabiliteit over runtimes, terwijl compilers en DSL's, waaronder TVM en Triton, kernels genereerden die op GPU-architecturen waren afgestemd. Ondertussen maakte NVIDIA's introductie van NVLink in 2016 en de daaropvolgende NVSwitch coherente high-bandwidth fabric mogelijk, waardoor meerdere GPU's zich als één grote accelerator konden gedragen voor dataparallelle en model-parallelle training. Het resultaat is een general-purpose engine wiens mogelijkheden ver uitstijgen boven het oorspronkelijke doel.

GPU's zijn nu de ruggengraat van exascale-simulaties, ondersteunen realtime inferentie voor spraak en visie, en versnellen data-analyse pipelines over publieke clouds. Hun evolutie heeft de industrie ook geleerd dat software-ecosystemen net zo bepalend kunnen zijn als silicium, en dat geheugensnelheid en verbindingen belangrijke prestatiekenmerken zijn. Aankondigingen zoals NVIDIA's Blackwell-architectuur van 2024, die gemengde precisie-ondersteuning verlengt en transformer-centrische training bevordert, benadrukken hoe nauw de hardware aansluit bij moderne AI-werkbelastingen. Van vroege framebuffers tot multi-petaflop accelerators, de opkomst van de GPU laat zien hoe gerichte innovatie, in combinatie met toegankelijke programmeermodellen, een gespecialiseerde coprocessor kan transformeren tot de ruggengraat van de hedendaagse computing.