Los procesadores gráficos comenzaron su trayectoria como asistentes del CPU, moviendo píxeles por la pantalla y acelerando los escritorios con ventanas. A lo largo de más de tres décadas, cambios arquitectónicos cuidadosos y un software en maduración los transformaron en los motores de computación paralela más importantes de nuestra era. La plataforma CUDA de NVIDIA desbloqueó la programación de propósito general a gran escala, y el aprendizaje profundo encontró rápidamente un hogar natural en este hardware orientado al rendimiento. Al mismo tiempo, la minería de criptomonedas expuso tanto el rendimiento bruto como la volatilidad del mercado que puede desatar un paralelismo masivo. Seguir este camino ilumina cómo un periférico que antes era especializado se convirtió en algo central para el descubrimiento científico, la inteligencia artificial moderna e incluso los sistemas financieros.

La trayectoria de la GPU es importante porque demuestra cómo las limitaciones de ingeniería pueden redirigir todo el rumbo de la computación. Los adaptadores de pantalla solían estar optimizados de manera muy específica para bitmaps y escaneos, pero la demanda implacable de realismo en los videojuegos dio lugar a hardware que sobresale en realizar muchas operaciones simples en paralelo. Esa misma capacidad—ancho de banda de memoria alto, cambio rápido de contexto y enorme concurrencia—se traduce perfectamente en álgebra lineal. Como resultado, las GPUs se convirtieron en el motor por defecto para cargas de trabajo tan diversas como el entrenamiento de redes neuronales, la aceleración de simulaciones científicas y, durante un tiempo, la minería de criptomonedas.

Su ascenso también transformó las cadenas de suministro, el diseño de centros de datos y los modelos de programación en toda la industria. Las primeras PCs dependían de adaptadores de pantalla simples como el MDA y CGA de IBM en los años 80, que luego se estandarizaron alrededor del VGA para la salida analógica. A medida que se fueron extendiendo las interfaces gráficas de usuario, proveedores como S3, Matrox y ATI construyeron aceleradores 2D que aceleraban BitBLT, el dibujo de líneas y la superposición de video. El Puerto Gráfico Acelerado a finales de los 90 mejoró el rendimiento entre la CPU y la memoria gráfica, permitiendo escenas más ricas.

Estos diseños aún seguían un modelo de función fija en gran medida: la tarjeta ejecutaba un conjunto limitado de tareas gráficas muy rápido, con poco espacio para cálculos generales. La búsqueda del realismo 3D cambió la ecuación. La Voodoo de 3dfx popularizó la aceleración 3D para consumidores a mediados de los 90, mientras que APIs como OpenGL y Direct3D codificaron un pipeline que el hardware podía implementar de manera eficiente. La GeForce 256 de NVIDIA en 1999 integró la transformación y la iluminación en hardware e introdujo el término “GPU”, reflejando un papel más amplio que el mero despliegue gráfico.

Los shaders programables de la era DirectX 8 permitieron a los desarrolladores proporcionar pequeños programas para ejecutar por vértice y por píxel, y los shaders unificados de la era DirectX 10, que debutaron con la G80 de NVIDIA (GeForce 8800) en 2006, difuminaron las líneas de función fija en un gran conjunto de unidades aritméticas generales. El resultado fue un array de procesadores altamente paralelos con una jerarquía de memoria que, aunque ajustada para gráficos, era cada vez más utilizable para otras tareas paralelas de datos. Los investigadores exploraron rápidamente la computación de propósito general en este nuevo sustrato, primero deformando lenguajes de shaders y luego construyendo herramientas hechas a medida. Proyectos como BrookGPU de Stanford demostraron que muchos núcleos científicos podían mapearse en pipelines gráficos, resaltando el potencial de cómputo latente.

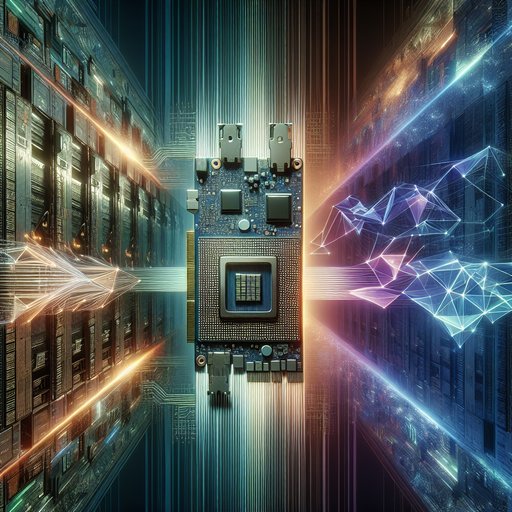

En 2006, NVIDIA introdujo CUDA, un modelo de programación similar a C que expone hilos, bloques y una jerarquía de memoria diseñados explícitamente para el rendimiento. CUDA se envió con bibliotecas optimizadas como cuBLAS y cuFFT, proporcionando a los desarrolladores bloques de construcción de alto rendimiento. OpenCL llegó en 2008 como un estándar neutral para proveedores, y con el tiempo Vulkan compute, DirectCompute y Metal completaron las opciones multiplataforma. El aprendizaje profundo consolidó el papel de la GPU en la computación de alto rendimiento.

En 2012, la red neuronal convolucional AlexNet fue entrenada en GPUs de NVIDIA usando código basado en CUDA, logrando resultados innovadores en ImageNet y demostrando que la retropropagación y las convoluciones prosperan en el paralelismo de las GPUs. La biblioteca cuDNN de NVIDIA, introducida en 2014, estandarizó primitivas de alto rendimiento para redes neuronales y se convirtió en una dependencia crítica para marcos como TensorFlow y PyTorch. El hardware co-evolucionó: el V100 de Volta (2017) añadió Núcleos Tensor para matemáticas matriciales de precisión mixta, que luego se expandieron en el A100 de Ampere (2020) y el H100 de Hopper (2022) con soporte para BF16 y FP8 y el Motor Transformer para la gestión automatizada de precisión. El entrenamiento con múltiples GPUs se escaló a través de NCCL para colectivas y conexiones de alta velocidad como NVLink y NVSwitch, permitiendo que clústeres de nodo único y múltiples nodos entrenaran modelos cada vez más grandes.

Las GPUs en centros de datos se convirtieron en sistemas tanto como en chips, con empaquetado, memoria y conexiones diseñadas para cargas de trabajo de IA sostenidas. La Memoria de Alto Ancho de Banda (HBM2 y HBM3) ofreció un ancho de banda masivo en el paquete para mantener alimentados miles de núcleos, mientras que los módulos SXM y las placas base densas optimizaban la potencia y la termodinámica. Características como Multi-Instance GPU (MIG) en Ampere dividieron un único acelerador en secciones aisladas, mejorando la utilización para cargas de trabajo mixtas. Los diseños DGX y HGX de NVIDIA proporcionaron planos de referencia para proveedores y nubes, mientras que los controladores en contenedores y los entornos de ejecución compatibles con CUDA simplificaron el despliegue a gran escala.

AMD avanzó con una pila alternativa con ROCm y HIP en aceleradores como MI200 y MI300, y capas de portabilidad como OpenCL y SYCL ampliaron las opciones para la computación heterogénea. La demanda del consumidor contaba una historia paralela en criptomonedas. La minería de Bitcoin comenzó en CPUs, pero para 2010 las GPUs dominaron gracias a su rendimiento muy superior en cargas de trabajo SHA-256, con algunas tarjetas AMD Radeon destacándose gracias a eficientes pipelines enteros. Los ASICs especializados desplazaron a las GPUs para Bitcoin entre 2013 y 2014, pero el algoritmo Ethash de Ethereum, que requiere mucha memoria, mantuvo a las GPUs relevantes hasta la transición de la red en 2022 a prueba de participación.

Los aumentos en la minería en 2017 y nuevamente en 2020-2021 ajustaron el suministro de GPUs, lo que llevó a medidas como variantes de “Lite Hash Rate” e influyó en los precios y la disponibilidad tanto para jugadores como para investigadores. Estos ciclos destacaron cómo una sola clase de aplicación puede influir en todo un mercado de hardware cuando la mercancía es el cómputo paralelo. La historia de la programabilidad explica gran parte del cambio duradero de gráficos a computación general. Las APIs consistentes de CUDA, las bibliotecas matemáticas en evolución y las herramientas hicieron práctico portar códigos científicos y núcleos de aprendizaje automático sin tener que escribir manualmente código de shader.

Las opciones neutrales para proveedores garantizaron que investigadores y empresas pudieran diversificar sus enfoques, incluso cuando gran parte del ecosistema de aprendizaje profundo se estandarizó en CUDA y cuDNN por razones de rendimiento. Los estándares de interoperabilidad como ONNX ayudaron a la portabilidad de modelos a través de entornos de ejecución, mientras que compiladores y DSLs, incluyendo TVM y Triton, generaron núcleos adaptados a las arquitecturas de GPUs. Mientras tanto, la introducción de NVLink por parte de NVIDIA en 2016 y el posterior NVSwitch habilitaron tejidos coherentes de alto ancho de banda que permitieron que múltiples GPUs se comportaran como un único gran acelerador para entrenamiento de datos paralelos y modelos paralelos. El resultado es un motor de propósito general cuyas capacidades superan con creces su mandato original.

Las GPUs ahora son la base de simulaciones de clase exascale, alimentan inferencias en tiempo real para voz y visión, y aceleran pipelines de análisis de datos en nubes públicas. Su evolución también enseñó a la industria que los ecosistemas de software pueden ser tan decisivos como el silicio, y que el ancho de banda de memoria y las conexiones son características de rendimiento de primer nivel. Anuncios como la arquitectura Blackwell de NVIDIA para 2024, que extiende el soporte de precisión mixta y avanza en el entrenamiento centrado en transformadores, subrayan cuán de cerca el hardware sigue las cargas de trabajo modernas de IA. Desde los primeros buffers de trama hasta los aceleradores de múltiples petaflops, el ascenso de la GPU demuestra cómo la innovación dirigida, junto con modelos de programación accesibles, puede transformar un coprocesador especializado en la columna vertebral de la computación contemporánea.