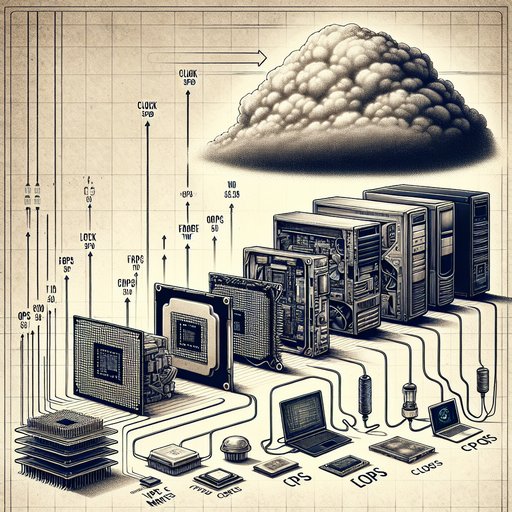

Het meten van computerprestaties is nooit een kwestie van één getal geweest, maar de industrie heeft keer op keer geprobeerd het te reduceren tot een hoofdmeter. In het verleden waren MIPS en kloksnelheid belangrijk, daarna werd FLOPS de koning in de HPC-wereld, en tegenwoordig vergelijken gebruikers gaming frame-tijden, webresponsiviteit en batterijduur. Elke verschuiving weerspiegelt een dieperliggende technologische verandering: van single-core CPU's naar heterogene systemen, van lokale schijven naar clouddiensten, en van batchverwerking naar interactieve latentie. Begrijpen hoe en waarom benchmarks zich hebben ontwikkeld, onthult niet alleen wat computers goed kunnen, maar ook waarom traditionele meetwaarden vaak tekortschieten bij het voorspellen van de ervaring in de echte wereld.

Prestatiemetrics zijn belangrijk omdat computers in de loop der tijd zowel diverser als specialistischer zijn geworden. Een desktop die frames rendert, een telefoon die een webpagina laadt, en een datacenter dat miljoenen queries verwerkt, benadrukken verschillende knelpunten. Naarmate architecturen meer cores, bredere vectoren, grotere caches en versnellers toevoegden, stopte een enkel scalair getal met het duidelijk weergeven van de door de gebruiker ervaren snelheid. De evolutie van benchmarks volgt deze verschuivingen en legt uit hoe metingen kunnen helpen of misleiden bij ontwerp- en aankoopbeslissingen.

MIPS, of miljoenen instructies per seconde, trok aanvankelijk de aandacht omdat het eenvoudig en blijkbaar vergelijkbaar was. In de praktijk kan een instructie op de ene ISA meer of minder werk verrichten dan op een andere, waardoor vergelijkingen van MIPS tussen verschillende architecturen misleidend zijn. De kwaliteit van de compiler, de mix van instructies en microarchitecturale kenmerken zoals out-of-order uitvoering en caches beïnvloeden allemaal de MIPS op manieren die nauwelijks verband houden met de tijd die nodig is om een taak te voltooien. De industrie leerde dat IPC en kloksnelheid alleen niet bepalen hoe snel een bepaalde werklast wordt afgerond.

FLOPS kreeg een prominente rol in high-performance computing omdat veel wetenschappelijke codes gedomineerd worden door floating-point berekeningen. Benchmarks zoals LINPACK, geoptimaliseerd voor dichte lineaire algebra, werden de basis voor de TOP500-lijst, die machines beloont die extreme FP-doorvoer kunnen leveren. Deze nadruk stimuleerde vectorunits en GPU-versnelling, maar benadrukte ook een kloof: veel HPC-werklasten worden beperkt door geheugensnelheid en latentie, niet door rauwe FLOPS. Inspanningen zoals HPCG zijn ontstaan om meer geheugengebonden patronen te vertegenwoordigen, en herinneren de gebruikers eraan dat piekniveaus alleen relevant zijn wanneer een programma de rekeneenheden kan voorzien van data.

Toepassingsgerichte suites probeerden vergelijkbaarheid en realisme in balans te brengen. SPEC CPU standaardiseerde compilerinstellingen en werklasten om de prestaties van gehele en floating-point bewerkingen over generaties te vergelijken, terwijl SPECjbb en SPECjEnterprise de nadruk legden op Java-servers en middleware. Databasebenchmarks zoals TPC-C en TPC-H maten doorvoer en analytische prestaties, wat invloed had op opslagindelingen, cachingstrategieën en gelijktijdigheidscontrole. Deze suites verbeterden de nauwkeurigheid en reproduceerbaarheid, maar leveranciers optimaliseerden nog steeds agressief voor deze benchmarks, wat soms leidde tot spectaculaire scores die niet vertaalden naar betere prestaties in de daadwerkelijke mix van queries en data van een klant.

Op klantensystemen maakten synthetische microbenchmarks plaats voor scenario-gedreven tests die het dagelijks gebruik nabootsen. De webresponsiviteit wordt vastgelegd door tools zoals Speedometer, die DOM-updates, timers en JavaScript-engines over verschillende frameworks testen. Contentcreatie en productiviteit steunen op tools zoals Cinebench en PCMark om rendering, codering en kantoorwerkstromen te representeren, terwijl cross-platform tests zoals Geekbench gericht zijn op draagbaarheid ten koste van strikte werklastcontrole. Opslag en geheugen komen ook zichtbaarder in beeld, aangezien willekeurige I/O-latentie, wachtrijdiepte en cachemisses de ervaringen kunnen domineren bij het starten van apps of het compileren van code.

Gamingbenchmarks benadrukken waarom gemiddelden het verhaal kunnen verbergen. Frames per seconde bieden een snelle indicator, maar verdelingen van frame-tijden, 1% lage en 0,1% lage waarden onthullen stotter- en tempo-issues waar spelers daadwerkelijk last van hebben. Moderne engines jongleren met asset streaming, shadercompilatie, fysica en AI over CPU-threads en GPU-wachtrijen, waardoor knelpunten van scène tot scène verschuiven. API-keuzes en de volwassenheid van drivers zijn belangrijk, en technologieën zoals DirectStorage veranderen of de prestaties worden beperkt door de GPU, CPU of opslag.

Een systeem dat een hoog gemiddeld FPS behaalt maar onregelmatige frame-tijden heeft, voelt slechter aan dan een machine met een lager FPS maar consistente pacing. Traditionele metrics falen vaak omdat echte werklasten het hele systeem onder druk zetten, niet alleen een enkele rekeneenheid. Doorvoer en latentie trekken in verschillende richtingen, en tail latency—die p95 en p99 vertragingen—kunnen de gebruikerservaring bepalen of de service-level doelstellingen in gevaar brengen. Mobiele en datacenterplatforms opereren ook binnen vermogens- en thermische budgetten, waardoor prestaties per watt, aanhoudende snelheid en throttling-gedrag net zo belangrijk zijn als pieken.

De geheugengrens, Amdahl’s Wet, de planning van besturingssystemen en achtergrondtaken vervagen verder de grens tussen de theoretische mogelijkheden van een chip en de tijd die nodig is om een taak te voltooien. Een betere aanpak combineert rigor met relevantie. Representatieve, end-to-end scenario’s naast gerichte microbenchmarks onthullen waar de knelpunten zich bevinden en hoe verbeteringen zich vertalen naar gebruikersresultaten. Voor AI categoriseert MLPerf training en inferentie over modellen en datatypes, terwijl in gaming het publiceren van frame-tijd traceringen met duidelijke instellingen en vastlegmethoden vertrouwen opbouwt.

Voor algemene computing stemmen maatregelen zoals tijd-tot-eerste-interactie, compileertijd tot voltooiing, of batterij-genormaliseerde doorvoer vaak overeen met wat mensen daadwerkelijk waarderen. Geen enkele score kan dit alles samenvatten, maar een transparante suite van metrics kan de afwegingen verhelderen en zowel ontwerp als inkoop met minder verrassingen begeleiden.