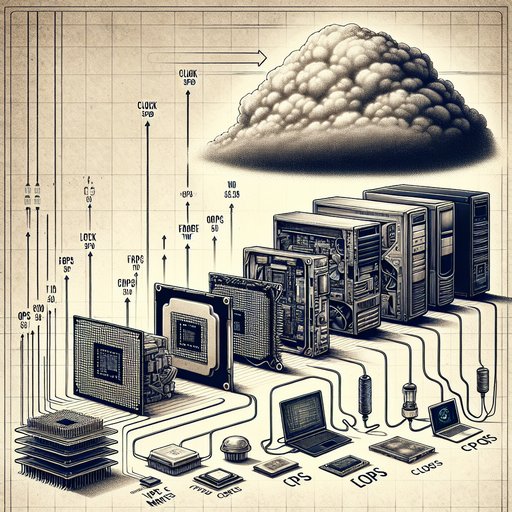

Medir el rendimiento de las computadoras nunca ha sido cuestión de un solo número, sin embargo, la industria ha intentado una y otra vez reducirlo a una métrica principal. En las primeras etapas, se valoraban los MIPS y la velocidad de reloj, luego el HPC coronó los FLOPS, y ahora los usuarios comparan los tiempos de fotogramas en juegos, la capacidad de respuesta en la web y la duración de la batería. Cada cambio refleja una transformación tecnológica más profunda: desde CPUs de un solo núcleo hasta sistemas heterogéneos, desde discos locales hasta servicios en la nube, y desde el rendimiento por lotes hasta la latencia interactiva. Comprender cómo y por qué han evolucionado los benchmarks no solo revela lo que las computadoras hacen bien, sino también por qué las métricas tradicionales a menudo no logran predecir la experiencia en el mundo real.

Los métricas de rendimiento son importantes porque las computadoras se han vuelto más diversas y especializadas con el tiempo. Un escritorio que renderiza cuadros, un teléfono que carga una página web y un centro de datos que atiende millones de consultas enfatizan cuellos de botella distintos. A medida que las arquitecturas incorporaron más núcleos, vectores más amplios, cachés más grandes y aceleradores, un solo número escalar dejó de reflejar claramente la velocidad percibida por el usuario. La evolución de los benchmarks sigue estos cambios y explica cómo la medición puede guiar, o desviar, las decisiones de diseño y compra.

MIPS, o millones de instrucciones por segundo, capturó la atención en sus inicios porque era simple y aparentemente comparable. En la práctica, una instrucción en una ISA puede hacer más o menos trabajo que en otra, lo que hace que las comparaciones de MIPS entre arquitecturas sean engañosas. La calidad del compilador, la mezcla de instrucciones y características microarquitectónicas como la ejecución fuera de orden y las cachés afectan a los MIPS de maneras que apenas se relacionan con el tiempo de finalización de tareas. La industria aprendió que el IPC y la frecuencia del reloj por sí solos no determinan qué tan rápido se completa una carga de trabajo determinada.

Los FLOPS se hicieron notorios en la computación de alto rendimiento porque muchos códigos científicos se basan en matemáticas de punto flotante. Benchmarks como LINPACK, optimizados para álgebra lineal densa, se convirtieron en la base de la lista TOP500, premiando a las máquinas que logran un rendimiento extremo en FP. Ese enfoque catalizó unidades vectoriales y aceleración por GPU, pero también destacó una brecha: muchas cargas de trabajo de HPC están limitadas por el ancho de banda de memoria y la latencia, no por los FLOPS en bruto. Iniciativas como HPCG surgieron para representar patrones más limitados por la memoria, recordando a los profesionales que las tasas máximas solo importan cuando un programa puede alimentar las unidades de cálculo.

Conjuntos enfocados en aplicaciones intentaron equilibrar la comparabilidad y el realismo. SPEC CPU estandarizó banderas del compilador y cargas de trabajo para comparar el rendimiento de enteros y de punto flotante a través de generaciones, mientras que SPECjbb y SPECjEnterprise se centraron en servidores Java y middleware. Benchmarks de bases de datos como TPC-C y TPC-H midieron el rendimiento y la capacidad analítica, influyendo en distribuciones de almacenamiento, estrategias de caché y control de concurrencia. Estos conjuntos mejoraron el rigor y la reproducibilidad, aunque los proveedores todavía los ajustaban agresivamente, a veces obteniendo puntuaciones espectaculares que no se traducían en un mejor rendimiento en la mezcla real de consultas y datos de un cliente.

En sistemas de cliente, los microbenchmarks sintéticos dieron paso a pruebas basadas en escenarios que reflejan el uso diario. La capacidad de respuesta de la web se mide con herramientas como Speedometer, que evalúan actualizaciones del DOM, temporizadores y motores de JavaScript a través de diferentes frameworks. La creación de contenido y la productividad dependen de herramientas como Cinebench y PCMark para representar flujos de trabajo de renderizado, codificación y oficina, mientras que pruebas multiplataforma como Geekbench se enfocan en la portabilidad a expensas de un control estricto de la carga de trabajo. El almacenamiento y la memoria también entran en juego de manera más visible, ya que la latencia de I/O aleatorio, el comportamiento de profundidad de cola y los fallos de caché pueden dominar experiencias como iniciar aplicaciones o compilar código.

Los benchmarks de juegos destacan por qué los promedios pueden ocultar la historia. Los cuadros por segundo ofrecen una evaluación rápida, pero las distribuciones de tiempo de cuadro, los mínimos del 1% y los mínimos del 0.1% revelan problemas de tartamudeo y ritmo que los jugadores realmente notan. Los motores modernos equilibran la transmisión de activos, la compilación de shaders, la física y la IA a través de hilos de CPU y colas de GPU, por lo que los cuellos de botella cambian de escena a escena. Las elecciones de API y la madurez de los controladores son importantes, y tecnologías como DirectStorage cambian si el rendimiento está limitado por la GPU, la CPU o el almacenamiento.

Un sistema que muestra un alto promedio de FPS pero sufre tiempos de cuadro erráticos se sentirá peor que una máquina con menos FPS pero con un ritmo constante. Las métricas tradicionales a menudo fallan porque las cargas de trabajo reales estresan todo el sistema, no solo una única unidad de cómputo. El rendimiento y la latencia tiran en direcciones diferentes, y la latencia de cola—esos retrasos p95 y p99—pueden definir la satisfacción del usuario o incumplir los objetivos de nivel de servicio. Las plataformas móviles y de centros de datos también operan bajo presupuestos de energía y térmicos, haciendo que el rendimiento por vatio, la velocidad sostenida y el comportamiento de estrangulación sean tan importantes como los picos.

La pared de memoria, la Ley de Amdahl, la programación de sistemas operativos y las tareas en segundo plano difuminan aún más la línea entre la capacidad teórica de un chip y el tiempo que lleva completar un trabajo. Un enfoque mejor combina rigor con relevancia. Escenarios representativos, de extremo a extremo, junto con microbenchmarks específicos, exponen dónde están los cuellos de botella y cómo las mejoras se traducen en resultados para el usuario. Para IA, MLPerf categoriza el entrenamiento y la inferencia a través de modelos y tipos de datos, mientras que en los juegos, publicar trazas de tiempo de cuadro con configuraciones claras y métodos de captura genera confianza.

Para la computación general, medidas como el tiempo hasta la primera interacción, el tiempo de compilación hasta la finalización o el rendimiento normalizado por batería a menudo se alinean con lo que la gente realmente valora. Ninguna puntuación única puede resumir todo esto, pero un conjunto de métricas transparente puede aclarar los compromisos y guiar tanto el diseño como la compra con menos sorpresas.