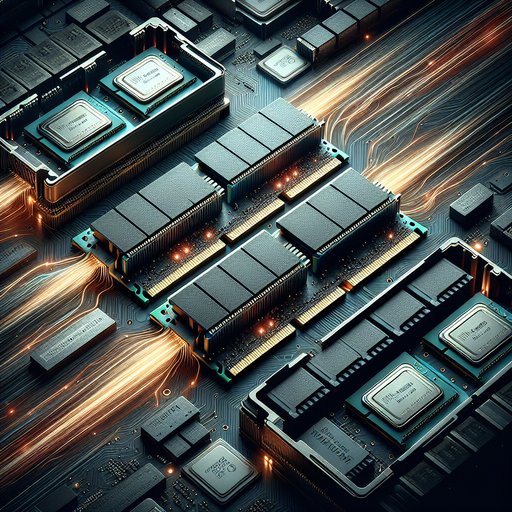

La memoria principal ocupa un lugar clave en cada sistema informático, actuando como un puente entre las CPUs rápidas y los aceleradores con un almacenamiento mucho más lento. La evolución de DDR4 a DDR5 y la exploración de memorias de clase de almacenamiento como 3D XPoint muestran cómo los diseñadores buscan más ancho de banda y capacidad mientras lidian con los persistentes límites de latencia. A medida que aumenta el número de núcleos, proliferan las GPUs integradas y las cargas de trabajo que requieren grandes cantidades de datos crecen, la diferencia entre un sistema que mantiene alimentadas sus unidades de ejecución y uno que se detiene a menudo se determina por el comportamiento de la memoria bajo presión. Comprender qué ha cambiado en las generaciones de DDR y cómo se integran las nuevas capas entre DRAM y NAND aclara por qué algunas aplicaciones escalan de manera fluida mientras que otras alcanzan límites mucho antes de que la CPU se quede sin potencia aritmética.

La memoria es crucial porque el rendimiento a menudo no está limitado por la capacidad de cómputo, sino por la rapidez con la que se pueden entregar los datos a las unidades de procesamiento. El aumento constante en la paralelización de CPUs y el ancho de vector en la industria ha incrementado la demanda de transacciones de memoria concurrentes y de alto ancho de banda. Mientras tanto, las realidades físicas de las celdas DRAM han mantenido la latencia de acceso fundamental prácticamente constante en nanosegundos a lo largo de las generaciones, creando una tensión que los arquitectos resuelven con más canales, colas más profundas y un agendamiento más inteligente. La transición de DDR4 a DDR5 se debe ver más como una respuesta a este desequilibrio que como un simple aumento de velocidad.

DDR4 estableció la base para las plataformas modernas, con tasas de datos que generalmente oscilan entre 2133 y 3200 mega-transferencias por segundo y un canal de 64 bits por DIMM. Los grupos de bancos y la actualización por banco, introducidos y perfeccionados a través de DDR3/DDR4, mejoraron la concurrencia al permitir que múltiples operaciones progresen con menos conflictos. Al mismo tiempo, las latencias de acceso absolutas típicas para lecturas aleatorias se mantuvieron en el orden de decenas de nanosegundos, lo que significa que el software percibía mejoras de rendimiento principalmente cuando se mejoraba el paralelismo o la localidad. A medida que los servidores pasaron de cuatro a seis y luego a ocho canales de memoria por socket, el ancho de banda agregado escaló para mantenerse al ritmo de los procesadores multinúcleo, incluso cuando la latencia de acceso individual apenas se movía.

DDR5 incrementa el ancho de banda por diseño, con tasas de datos estándar JEDEC que comienzan en 4800 MT/s y se extienden más allá de 6400 MT/s a medida que las plataformas maduran. Cada UDIMM se divide en dos subcanales independientes de 32 bits, aumentando la eficiencia de los comandos y reduciendo el tiempo de bus desperdiciado al transferir pequeñas ráfagas de datos. La longitud de la ráfaga se duplicó a 16, y el número de grupos de bancos aumentó, ampliando el grupo de páginas abiertas y las oportunidades para que el controlador planifique la ejecución en torno a los conflictos. La gestión de energía en el módulo a través de un PMIC y la adición de ECC en el chip para la fiabilidad de las celdas mejoran la integridad de la señal y el rendimiento sin reemplazar el ECC de extremo a extremo donde se requiere.

A pesar del salto en el ancho de banda, DDR5 no reduce mágicamente la latencia real; de hecho, los módulos iniciales a menudo tienen un mayor conteo de ciclos para los tiempos, y la latencia absoluta en nanosegundos puede ser similar o ligeramente peor que la de un DDR4 rápido. Una comparación sencilla ilustra el punto: DDR4-3200 con CL16 produce aproximadamente 10 ns de latencia CAS, mientras que DDR5-6000 con CL36 se sitúa alrededor de 12 ns, sin considerar tRCD y tRP. Los controladores de memoria modernos mitigan esto extrayendo paralelismo a nivel de memoria, manteniendo muchas solicitudes en vuelo y aprovechando la estructura de banco ampliada para ocultar los retrasos individuales de acceso. Las cargas de trabajo que pueden emitir flujos concurrentes, como gráficos integrados o escaneos de grandes datos, se benefician enormemente del ancho de banda de DDR5, incluso si la latencia del primer byte no cambia.

Las plataformas de servidores magnifican estos efectos al emparejar DDR5 con más canales de memoria y DIMMs de mayor capacidad, aumentando tanto el ancho de banda como la huella para conjuntos de datos en memoria. Los CPUs más nuevos exponen ocho o más canales DDR5 por socket, y las técnicas de apilamiento de chips aumentan las capacidades por DIMM, permitiendo que bases de datos, marcos de análisis y hosts de virtualización mantengan más datos críticos cerca del cómputo. La mejora en la entrega de energía en el DIMM ayuda a mantener la integridad de la señal a velocidades más altas, lo cual es crítico en placas de servidor densamente pobladas. El resultado final es un mayor rendimiento sostenido para cargas de trabajo paralelas intensivas en memoria, mientras que el código de acceso aleatorio de un solo hilo ve ganancias más modestas a menos que el software mejore la localidad y la capacidad de recuperación anticipada.

3D XPoint, comercializado por Intel como Optane, mostró un camino complementario al insertar un nivel persistente y direccionable por byte entre DRAM y NAND. En forma de DIMM, sus latencias de lectura eran varias veces mayores que las de DRAM, pero muy por debajo de las de NAND, y en forma NVMe entregaba accesos en microsegundos de un solo dígito, dramáticamente más rápidos que los SSD típicos. Las implementaciones en centros de datos lo utilizaron para expandir la memoria de manera económica y para acelerar metadatos, índices y registros pesados en escritura gracias a una mayor resistencia que la NAND. Aunque tanto Intel como Micron cesaron la producción de 3D XPoint para 2022, su uso en el mundo real validó la jerarquía de memoria: colocar medios grandes y ligeramente más lentos cerca de la CPU reduce la presión sobre la DRAM, disminuye la amplificación de E/S y mejora las latencias de cola para servicios intensivos en datos.

El impacto práctico del ancho de banda y la latencia varía según las características de la carga de trabajo. Las GPUs integradas escalan casi linealmente con el ancho de banda de memoria porque carecen de VRAM dedicada, haciendo que el mayor rendimiento de DDR5 sea especialmente valioso para juegos en iGPUs y para cómputo similar a GPU en APUs. La inferencia de IA con grandes embeddings, el análisis en memoria y el recorrido de grafos se benefician cuando muchas solicitudes pendientes pueden superponerse, mientras que el código ramificado, que persigue punteros y elude a los prefetchers, sigue estando limitado por la latencia. Los desarrolladores notan la diferencia en el perfilado: los ciclos de espera por memoria disminuyen cuando hay patrones de concurrencia y transmisión, mientras que las caminatas de punteros en una sola línea siguen limitadas por los nanosegundos del primer acceso.

Mirando hacia el futuro, la jerarquía sigue ampliándose: HBM conectado a aceleradores entrega cientos de gigabytes por segundo por pila para núcleos masivamente paralelos, mientras que DDR5 ancla el cómputo de propósito general con amplia capacidad y eficiencia de costos. Interconexiones coherentes como CXL añaden nuevas formas de conectar memoria ampliada a latencias algo más altas, lo que permite la agrupación y jerarquización sin necesidad de reconfigurar las aplicaciones. Estas tendencias están cambiando la ingeniería del rendimiento hacia asignaciones conscientes de la topología, colocación de datos consciente de NUMA, y algoritmos que maximizan el acceso contiguo y paralelo. Los ganadores son los sistemas que tratan la memoria no como un monolito, sino como un conjunto de niveles, cada uno explotado por lo que hace mejor.

La conexión entre DDR4 y DDR5, así como con la memoria de clase almacenamiento, es clara: el ancho de banda y el paralelismo están escalando agresivamente, mientras que la latencia intrínseca de DRAM avanza lentamente. El hardware responde con más canales, bancos, subcanales y controladores más inteligentes; el software responde con diseños de datos y patrones de acceso que convierten esa estructura en trabajo útil. Al emparejar las cargas de trabajo con el nivel adecuado—DRAM rápida para datos calientes y aleatorios; DDR5 de alto ancho de banda para flujos paralelos; memoria persistente para caché de capacidad cercana—los arquitectos pueden transformar posibles cuellos de botella en rendimiento. La evolución se trata menos de perseguir una única métrica y más de equilibrar toda la tubería para que el cómputo, la memoria y el almacenamiento tiren en la misma dirección.